Simulationshypothese

Kosmologie

© 2016

- 2025

Basisiwssen|

Grundidee der Simulationsypothese|

Kann man die Simulationshypothese testen?|

Quantenphysikalische Testidee für die Hypothese|

Lichtgeschwindigkeit als Leistungsschoner?|

Historische Vorläufer: Scholastik|

Frühe Theoretisierung: Berkeley|

Seit den 1930er Jahren: das Gehirn im Tank|

Seit den 1960er Jahren: die Welt als Computer?|

Was ist die Gegenposition zur Simulationshypothese?|

Ein möglicher Sinn: kollaborative Physik|

Die Frage nach dem Zweck einer simulierten Welt|

Kinofilme zur Idee einer computersimulierten Welt|

Fußnoten

Basisiwssen

Als Simulationshypothese bezeichnet man die Idee, dass die von uns wahrgenommene Welt nicht materiell und beständig existiert. Vielmehr werden unsere Sinneseindrücke ständig neu erzeugt und uns sozusagen in die Sinne eingespielt. Frühere Fomulierungen dieses Gedankens sahen als Quelle der Sinneseindrücke oft Gott an. Die Simulationshypothese ersetzt Gott durch eine Art Weltcomputer. Das ist hier kurz vorgestellt.

Grundidee der Simulationsypothese

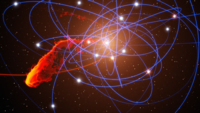

Nach der Simulationshypothese sind Menschen simulierte Wesen. Sie existieren demnach nicht real. Auch wird meist angenommen, dass auch das gesamte Universum einschließlich seiner kosmologischen Geschichte und auch die biologische Evolution von einer Art rechnendem Computer [16] simuliert sind. Verschiedene Interpreten der Theorie nehmen weiter an, dass die Rechenkapazität des hypothetischen Weltsimulators begrenzt ist.

Kann man die Simulationshypothese testen?

Eine Grundidee zur Überprüfung der Hypothese ist es, nach Fehlern in der Simulation zu suchen, nach einem "Riss in der Matrix". Ein Ansatz geht davon aus, dass die Simulation die Welt in eine Art räumliche Pixel einteilt. Zusätzlich geht man davon aus, dass die Rechenkapazität begrenzt ist. Verbindet man dies mit der Beobachtung eines sich stetig ausdehnenden Kosmos, dann muss irgendwann ein Punkt kommen, an dem die Rechenleistung des Weltsimulators für eine detaillierte Simulation nicht mehr ausreicht. Fehler könnte man zum Beispiel bei der Verteilung von Strahlung im Weltraum erwarten. [6]

Quantenphysikalische Testidee für die Hypothese

Unter der Annahme, dass die von wahrgenommene Realität simuliert ist und dass der simulierende Computer eine nur begrenzte Rechenkapazität hat, kann man folgern, dass die Simulation gewisse Optimierungsstrategien nutzen sollte. Eine Möglickeit ist, dass der sogenannte Kollaps der Wellenfunktion damit zusammenhängt, dass die Simulation die Realität nur dann "rendert", also detailgetreu nachzeichnet, wenn ein Beobachter die entsprechende Stelle betrachten möchte. Das Bewusstsein ist sozusagen der Bildschirm auf den die Realität generiert wird. Die Grundidee eines Tests ist es a) zu zeigen, dass der Kollaps der Wellenfunktion nur stattfindet, wenn ein Beobachter dies erzwingt und b) dass man in Experimenten inkonsistente Simulationsergebnisse erzeugen kann. [8]

Lichtgeschwindigkeit als Leistungsschoner?

Es ist eine gut bestätigte Erfahrungstatsache, dass nichts - Information eingeschlossen - sich schneller als mit der Lichtgeschwindigkeit c ausbreiten. Deutet man die Welt als Computersimulation mit verschiedenen in ihr frei entscheidenden Bewohnern (Spielern), und nimmt man ferner an, dass diese Welt nur konsistente Geschichten erzeugen soll, also eine gewisse Regelmäßigkeit, dann folgt daraus, dass der Weltsimulator Aktionen verschiedener Wesen in der Welt dort miteinander abgleichen muss, wo sich die Folgen raumzeitlich begegnen. Ist die Geschwindigkeit der Ausbreitung von Handlungsfolgen langsam, gibt es entsprechend weniger mögliche Kombinationen, die überprüft werden und entsprechend weniger Rechenleistung wird benötigt. Siehe auch 👉 Lichtgeschwindigkeit

Historische Vorläufer: Scholastik

Als Scholastik bezeichnet man eine Periode westeuropäischer Philosophie von etwa 1000 bis 1300. Ziel dieser Strömung war die Verbindung von christlichem Glauben mit strenger Logik und Philosophie. Der scholastisch gebildete Mystiker Eckehart sah die Welt als Gegenstand eines andauernden Schöpfungsaktes durch Gott. Damit ist die Welt nicht für sich alleine existent, sie wird gemacht: "Alles was Gott je vor sechstausend Jahren und mehr schuf, als Gott die Welt machte, das schafft Gott jetzt zumal." Und: "Alles was vergangen ist und alles was künftig ist, das schafft Gott im Innersten der Seele." [11]

Frühe Theoretisierung: Berkeley

Der irische Geistliche George Berkeley wandete sich gegen den erstarkenden (und zunehmend erfolgreichen) Materialismus seiner Zeit und formuliert spitz: "It is indeed an opinion strangely prevailing amongst men, that houses, mountains, rivers, and in a word all sensible objects have an existence natural or real..." Berkeley versucht zu zeigen, dass die Welt nur in Form von Ideen existiert. Seine Position war konsequent und extrem idealistisch und wäre möglicherweise mit der Vorstellung einer (computer)simulierten Welt verträglich. Lies mehr unter 👉 Berkeley-Frage

Seit den 1930er Jahren: das Gehirn im Tank

Im Jahr 1929 veröffentlichte der Mathematiker und Kristallograph John Desmond Bernal einen viel beachteten Aufsatz über die langfristige Zukunft der Menschheit [13]. Dort prophezeiht er, dass Menschen der Zukunft auf ein Gehirn in einem Zylinder reduziert seien. Der alte Körper wurde ersetzt durch technische Geräte. Diese verbinden das Gehirn mit Sensoren und Aktuatoren der Außenwelt. Bernal, ein vielfach ausgezeichneter Wissenschaftler, sieht darin keine Dystopie sondern einen großen Fortschritt. Dieses und ähnliche Bilder von Gehirnen, die nur noch über eine künstliche Peripherie mit der Außenwelt verbunden fasst man heute in der Philosophie unter dem Stichwort „Gehirn im Tank zusammen“. Ein solches Gehirn, und hier kommt die Außenwelthypothese wieder ins Spiel, hätte jedoch keine Chance eine bösartige Täuschung zu erkennen. Über die Sinneskanäle könnte man perfekte Simulation einspielen. Über die ausgehenden Nerventränge könnte die Simulation die gewünschten Aktionen des Gehirn erfassen und diese zur Erstellung der Simulation mit berücksichtigen. Siehe auch 👉 Gehirn im Tank

Seit den 1960er Jahren: die Welt als Computer?

Im Jahr 1969 veröffentliche der deutsche Computer-Pionier Konrad Zuse sein Buch über den Rechnenden Raum. Das sehr mathematisch gehaltene Werk stellt den Raum zellenartig aufgebaut vor. Alle Prozesse im Universum, so Zuses Gedanke, können durch Rechenschritte simuliert werden, die in den einzelnen Zellen ablaufen. Zeitgleich zu Zuse entwickelten in den USA die Physiker John Archibald Wheeler und Peter Putnahm die Idee einer quantenphysikalisch-informationtechnologischen Grundlage des Universums:

ZITAT:

"Orienting the world in a syntactic frame leaves no place for 'objectivity' or observation. The get around this the word is treated as an existential unit, and contact with the subjective is made as an abstraction from information processing categories (the world being treated as one big computer, with the more digital aspects concentrated in the brain, and the more analogue apsects organized as the world, and invoked on command)." [15]

"Orienting the world in a syntactic frame leaves no place for 'objectivity' or observation. The get around this the word is treated as an existential unit, and contact with the subjective is made as an abstraction from information processing categories (the world being treated as one big computer, with the more digital aspects concentrated in the brain, and the more analogue apsects organized as the world, and invoked on command)." [15]

Die Idee, dass den Erscheinungen der Welt eine Art Computersoftware zugrunde liegen könnte, wurde mit einer besonderen Berücksichtigung der quantenphysikalischen Besonderheiten der Naturgesetze später auch von Lothar Arendes betrachtet. [17]

Was ist die Gegenposition zur Simulationshypothese?

Die sogenannte Außenwelthypothese. Das Wort stammt von dem Physiker Ernst Mach. Mach hatte in einem einflussreichen Buch [4] Probleme mit dem gängigen Begriff der Materie herausgearbeitet. Er schlug dann eine Art Physik vor, die auf die modellhafte Annahme real existierende Materie verzichtete. Stattdessen liefere eine noch zu erschaffende Physik lediglich Aussagen darüber, nach welchen Gesetzmäßigkeiten ein Sinneseindruck in einen anderen Sinneseindruck übergeht. Machs Grundkonzept ließ sich im Sinne einer harten Physik auch auf eine Simulierte Welt anwenden. Diese Denkart grenzte er begrifflich ab von der Idee einer fest existierenden Welt der Materie. Siehe dazu unter 👉 Außenwelthypothese

Ein möglicher Sinn: kollaborative Physik

Seit dem Niedergang der mittelalterlichen Scholastik, mit ihrem Anspruch einer logisch fundierten Sinnstiftung unseres Sein, hat die Physik sich vollständig von der Frage des Sinns emanzipiert. Sie will und kann keine Antwort geben auf Fragen, die außerhalb ihrer Methodik liegen. Die Physik kann sehr gut beschreiben, wie schnell bestimmte Uran-Isotope über die Jahrmillionen zerfallen. Sie kann aber keinerlei Andeutung geben, wozu die Atome das tun. Siehe auch 👉 kollaborative Physik

Die Frage nach dem Zweck einer simulierten Welt

Die Idee, dass die Welt sozusagen aus Gedanken im Geiste Gottes besteht oder ein irgendwie gearteter Rechnenvorgang ist, bei der das Ergebnis am Ende wichtiger ist als der Weg dorthin führt zu der die Idee, dass die Welt nur ein Mittel zum Zweck ist. Siehe dazu auch den Artikel 👉 Weltzweck

Kinofilme zur Idee einer computersimulierten Welt

- Welt am Draht, 1974 von Reiner Werner Fassbinder

- Echtzeit. 1981-1983 (BRD) mit 👉 Konrad Zuse

- The Matrix, 1999

- The Thirteenth Floor, 1999

- Total Recall (Arnold Schwarzenegger)

Fußnoten

- [1] Silas Beane, Davoudi Zohreh, J. Savage Martin: Constraints on the Universe as a Numerical Simulation. 2012. doi:10.1140/epja/i2014-14148-0.

- [2] Stephen Wolfram, A New Kind of Science (Wolfram Media, 2002). Dort die Seite 1197. Die Welt als Zellularautomat.

- [3] Stanisław Lem: Aus den Erinnerungen Ijon Tichys I. In: Sterntagebücher. Suhrkamp, Frankfurt am Main 1978, ISBN 3-518-36959-8. Professor Corcoran erzeugt digitale Lebewesen und ergötzt sich an ihrer Ignoranz: http://www.seelengrund.de/2003/HTMLJeDi/Rezens/lem_corcoran.htm

- [4] Ernst Mach: Die Analyse der Empfindungen und das Verhältnis des Physischen zum Psychischen. Ersterscheinung: 1886.

- [5] George Berkeley: Treatise on the Principles of Human Knowledge. 1710. Mehr unter 👉 Berkeley-Frage

- [6] Nick Bostrom: Are We Living in a Computer Simulation? In: The Philosophical Quarterly. 53, 2003, S. 243–255, doi:10.1111/1467-9213.00309.

- [7] Konrad Zuse, 1969. Rechnender Raum. Braunschweig: Friedrich Vieweg & Sohn. 70 Seiten.

- [8] Tom Campbell, Houman Owhadi, Joe Sauvageau, David Watkinson: On Testing the Simulation Hypothesis. 2017. arXiv:1703.00058v2 [quant-ph]

- [9] Anil Ananthaswamy: Do We Live in a Simulation? Chances Are about 50–50. In: Scientific American. SCIENTIFIC AMERICAN, a Division of Springer Nature America, Inc. Online. October 13th, 2020.

- [10] Edward Hanna: Feynman Checkerboard as a Model of Discrete Space-Time. July 6th, 2006. Cornell University. arXiv:cs/0607018

- [11] Meister Eckhart: Predigt 20. Von Gott und Mensch. In: Eckharts mystische Schriften. Berlin 1903, S. 130-136.

- [12] Konrad Zuse: Rechnender Raum. Braunschweig: Friedrich Vieweg & Sohn. 1969. 70 Seiten. Siehe auch 👉 rechnender Raum

- [13] J. D. Bernal: The World, the Flesh & the Devil. An Enquiry into the Future of the Three Enemies of the Rational Soul. Foyle Publishing. 1929.

- [14] John Archibald Wheeler: Information, physics, quantum: The search for links. In: Zurek, Wojciech Hubert (ed.). Complexity, Entropy, and the Physics of Information. 1990. Redwood City, California: Addison-Wesley. ISBN 978-0-201-51509-1. (Definition von "participatory universe" auf Seite 5). Siehe auch 👉 partizipatorisches Universum

- [15] Peter Putnam: Some Comments on an Aspect of the Everett-Wheeler Model, 1970. Seite i (Abstract).

- [16] David Bohm benutzte ausdrücklich die Analogie zum einem Computerspiel: "Consciousness is much more of the implicate order than is matter . . . Yet at a deeper level [matter and consciousness] are actually inseparable and interwoven , just as in the computer game the player and the screen are united by participation." David Bohm, Statement of 1987, as quoted in Towards a Theory of Transpersonal Decision-Making in Human-Systems (2007) by Joseph Riggio, p. 66.

- [17] Eine spezielle Deutung der Physik im Sinne einer Software findet sich in: Lothar Arendes: Das Computer-Weltbild: Funktionen der Naturphilosophie in der Naturwissenschaft. Herausgegeben von Bod - Books on Demand, 2024. ISBN 13: 9783758313233. In einer Zusammenfassung zu dem Buch heißt es: "In Teil II werden die grundlegenden Phänomene und mathematischen Strukturen der wichtigsten physikalischen Theorie unserer Zeit, der Quantenmechanik, dargestellt und die Welt mit einem Computer verglichen, um damit die mathematischen Formalismen der theoretischen Physik semantisch zu deuten. Die mathematischen Strukturen der physikalischen Theorien besitzen danach eine wirkliche Existenzweise, insofern sie als Software in der Wirklichkeit, im Quantenvakuum, implementiert sind, und beobachtete Objekte sind Abbildungen auf dem Bildschirm bzw. auf den Bildschirmen des Weltcomputers, d.h. Projektionen in die Raumzeit. In Teil III werden aus dem Computer-Weltbild Anregungen für künftige wissenschaftliche Forschungen hergeleitet. Kernstücke bilden hierbei Überlegungen zum Leib-Seele-Problem und zum Funktionalismus der Biologie." Siehe auch 👉 Kopenhagener Deutung